Es que logros propios del cine y la literatura han abandonado el mundo de la ficción y hoy son realidades tangibles.

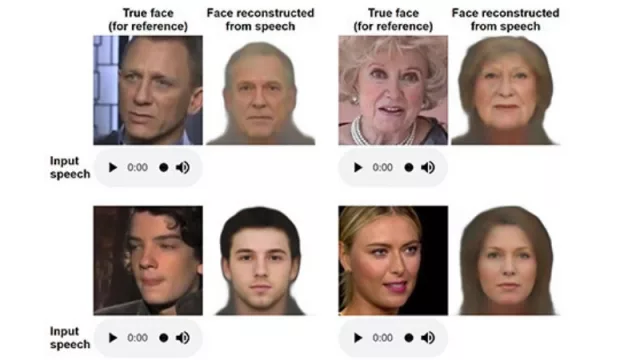

Uno de los más recientes y asombrosos ejemplos es Speech2Face, el sistema desarrollado por investigadores del MIT (Massachusetts Institute of Technology) que permite reconstruir el rostro de una persona con solo escuchar algunos segundos de su voz, tal como podés ver en el video que acompaña esta nota.

En la publicación en la cual expusieron los resultados de la investigación los seis responsables afirmaron: ¿Cuánto podemos inferir sobre la apariencia de una persona por la forma en que habla?

En este artículo, estudiamos la tarea de reconstruir una imagen facial de una persona a partir de una breve grabación de su voz hablando. Diseñamos y entrenamos una red neuronal profunda para realizar esta tarea utilizando millones de videos naturales de personas que hablan en sitios como YouTube. Durante la capacitación, nuestro modelo aprende sobre los rostros de las personas y sus correlaciones de voz. Esto le permite producir imágenes que capturan varios atributos físicos de los hablantes, como la edad, el género y la etnia. Esto se hace de manera auto-supervisada, utilizando la co-ocurrencia natural de rostros y habla en videos de Internet, sin la necesidad de modelar los atributos explícitamente. Nuestras reconstrucciones, obtenidas directamente del audio, revelan las correlaciones entre caras y voces. Evaluamos y cuantificamos numéricamente cómo, y de qué manera, nuestras reconstrucciones del audio de Speech2Face se asemejan a las verdaderas imágenes faciales de los altavoces.

Desde luego este tipo de experimentos conllevan un dilema ético al cual los investigadores no le rehúyen. “Aunque se trata de una investigación puramente académica, creemos que es importante discutir explícitamente en el documento un conjunto de consideraciones éticas debido a la posible sensibilidad de la información facial”, sostienen al abrir ese capítulo y añaden que el modelo informático no puede recuperar la verdadera identidad de una persona (es decir, una imagen exacta de su rostro). Esto se debe a que está capacitado para capturar características visuales (relacionadas con la edad, el género, etnia, etc.) que son comunes a muchas personas, y solo en los casos en que existe evidencia lo suficientemente sólida como para conectar esas características visuales con los atributos. Como tal, el modelo solo producirá caras de apariencia promedio, con características visuales que se correlacionan con el habla de entrada. No producirá imágenes de individuos específicos.

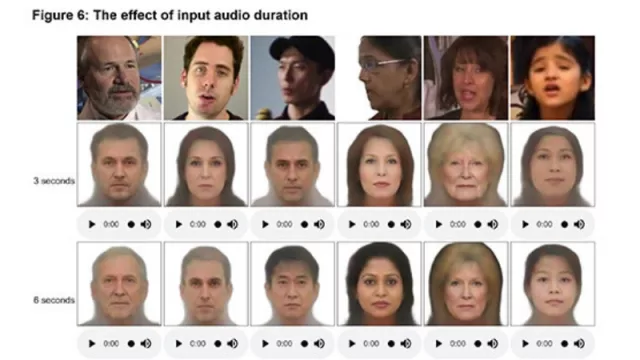

Los científicos utilizaron en el momento de la prueba para las reconstrucciones de rostros segmentos de voz de entrada de 3 segundos y 6 segundos respectivamente (en ambos casos usamos el mismo modelo). Como se observa en la imagen que acompaña esta nota, con una mayor duración del habla las caras reconstruidas capturan mejor los atributos faciales. Por cierto, en algunos casos, los resultados obtenidos son realmente asombrosos.

¿Qué más podrán lograr estas tecnologías de redes neuronales? No hay límites a la vista.

El paper completo con los resultados de la experiencia está aquí.

Tu opinión enriquece este artículo: